在生成式AI领域持续发力的字节跳动迎来了新的里程碑。旗下大模型豆包不仅在日均tokens使用量上取得了显著的增长,而且在今日的火山引擎Force原动力大会上宣布了一系列重要更新,特别是推出了具备强大视觉理解能力的新模型。这些进展标志着字节跳动在构建全面的多模态AI生态系统的道路上迈出了坚实的一步。

截至目前,豆包大模型的日均tokens使用量已超过4万亿,自发布以来短短7个月内增长了33倍以上,显示出强劲的发展势头。这一成就背后是字节跳动对技术研发和用户体验优化的不懈追求。随着用户基础不断扩大和技术迭代加速,豆包已经成为市场上不可或缺的一部分。

今日发布的视觉理解模型进一步增强了豆包的能力,使其能够更好地处理图像识别、内容理解和推理等任务。该模型的价格被设定为0.003元/千Tokens,比行业平均水平低85%,这无疑将吸引更多开发者和企业采用这项技术。更重要的是,它填补了之前豆包在视觉交互方面存在的空白,使得智能硬件产品如智能耳机、玩偶和台灯等可以实现更丰富的多媒体交互体验,而不仅仅是限于语音层面。西部证券的一份报告指出,视觉SoC将成为未来AI硬件终端的标准配置,并新增对NAND存储芯片的需求,这对于相关产业链公司来说是一个重要的市场机遇。

此外,字节跳动还计划于明年1月推出新一代视频生成大模型,以及展示了来自抖音旗下的即梦AI的新一代图片生成模型和动态海报功能。这些新产品和服务将进一步丰富豆包家族的产品线,同时也表明公司在视频内容创作领域的决心和技术实力。国盛证券认为,字节跳动已经拥有了开放式耳机音频技术和丰富的软件应用生态,未来有望成为AI眼镜市场的核心参与者之一。

值得注意的是,随着文字、视觉理解和视频生成等多个维度的大模型相继推出,“豆包+”生态系统逐渐成型,这可能导致字节跳动的算力需求急剧上升。据分析师估算,仅以当前的文字大模型为例,如果参考ChatGPT的MAU(月活跃用户)规模,那么推理和训练所需的A100显卡数量分别约为35万和12万个。而对于视频生成模型而言,其对算力的要求更高;例如,当即梦AI的Magic Video v2达到1亿MAU并每天生成10分钟视频时,预计需要约28万个英伟达H100 GPU,若MAU翻番,则需求将达到55万个。

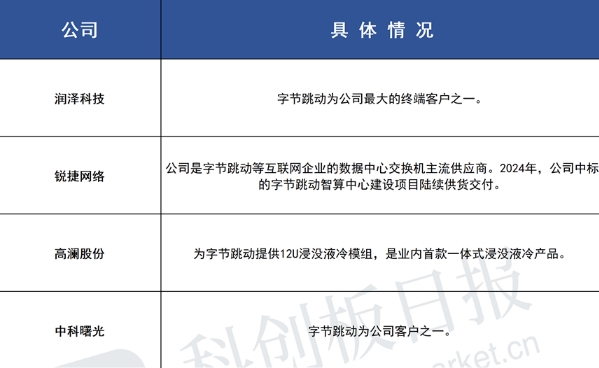

服务器代工厂英业达近期透露的信息也反映了这一点——本季度客户对AI服务器的需求超出预期,今年AI服务器营收有望同比增长2.5至3倍,而明年的出货量预计将继续攀升。民生证券分析称,随着豆包用户基数迅速扩大,算力中心扩建将成为必然趋势,从而带动AI服务器及相关基础设施如热管理解决方案的需求增加。特别是液冷技术,在满足高效散热的同时还能节省能源成本,有望开辟出广阔的市场空间。